La discesa del gradiente stocastico (SGD) è un algoritmo essenziale per l’ottimizzazione e l’addestramento di modelli di intelligenza artificiale. Questo articolo esplorerà i principi della SGD, il suo funzionamento, i vantaggi rispetto ad altri algoritmi di ottimizzazione e le sue applicazioni pratiche. Forniremo una panoramica approfondita e discorsiva, evidenziando come la SGD sia cruciale per il successo del deep learning e di altre tecniche AI.

Cos’è la Discesa del Gradiente Stocastico?

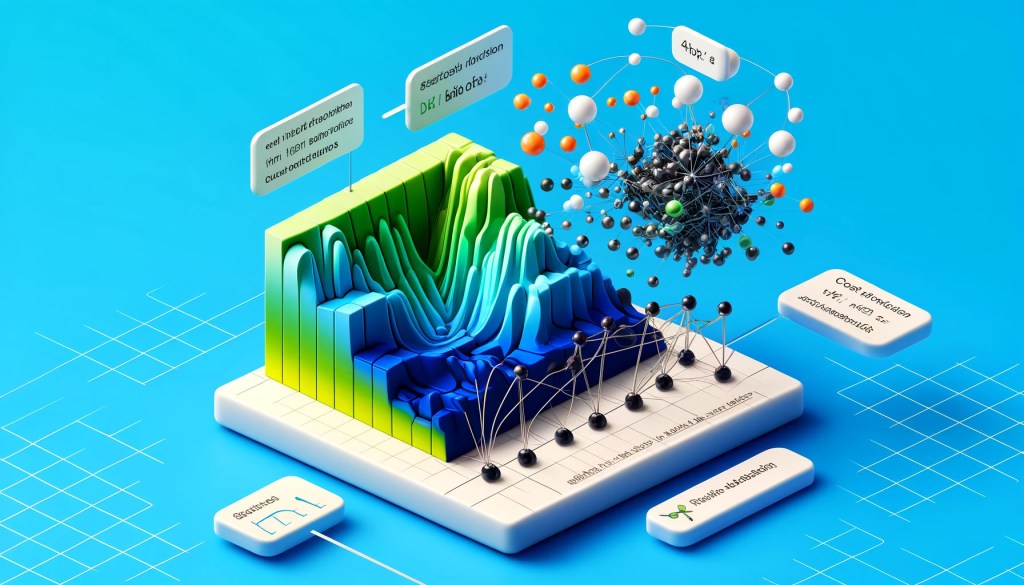

La discesa del gradiente stocastico è una variante della discesa del gradiente utilizzata per minimizzare una funzione di costo in modelli di apprendimento automatico. A differenza della discesa del gradiente tradizionale, che utilizza l’intero set di dati per calcolare i gradienti, la SGD utilizza un singolo esempio o un piccolo batch di esempi per aggiornare i pesi del modello.

Principi della Discesa del Gradiente Stocastico

- Calcolo del Gradiente:

- In ogni iterazione, la SGD seleziona un esempio o un batch di esempi dal set di dati e calcola il gradiente della funzione di costo rispetto ai pesi del modello.

- Aggiornamento dei Pesi:

- I pesi del modello vengono aggiornati sottraendo il gradiente calcolato, moltiplicato per un fattore di apprendimento (learning rate), dai pesi attuali.

- Iterazione e Convergenza:

- Questo processo viene ripetuto per molte iterazioni, con l’obiettivo di far convergere la funzione di costo a un valore minimo.

Vantaggi della Discesa del Gradiente Stocastico

- Efficienza Computazionale:

- La SGD è più efficiente rispetto alla discesa del gradiente batch, poiché aggiorna i pesi più frequentemente e richiede meno memoria.

- Convergenza Rapida:

- La frequenza degli aggiornamenti può portare a una convergenza più rapida, specialmente per set di dati di grandi dimensioni.

- Generalizzazione Migliore:

- L’introduzione di rumore nei gradienti, dovuta all’uso di singoli esempi, può aiutare il modello a generalizzare meglio su dati non visti, riducendo l’overfitting.

Applicazioni Pratiche della Discesa del Gradiente Stocastico

- Reti Neurali Profonde:

- Esempio: La SGD è ampiamente utilizzata nell’addestramento di reti neurali profonde, come le reti neurali convoluzionali (CNN) per il riconoscimento delle immagini e le reti neurali ricorrenti (RNN) per l’elaborazione del linguaggio naturale.

- Regressione Logistica:

- Esempio: La regressione logistica, utilizzata per problemi di classificazione binaria, viene spesso addestrata utilizzando la SGD per ottimizzare la funzione di costo logistica.

- Sistemi di Raccomandazione:

- Esempio: Le tecniche di factorizzazione della matrice, utilizzate nei sistemi di raccomandazione, beneficiano della SGD per aggiornare i fattori latenti e migliorare le raccomandazioni personalizzate.

Varianti della Discesa del Gradiente Stocastico

- SGD con Momento:

- Introduce un termine di momento che accelera il processo di convergenza e aiuta a superare i minimi locali.

- RMSprop:

- Adatta il learning rate per ogni parametro, migliorando la stabilità dell’addestramento e la velocità di convergenza.

- Adam:

- Combina le idee di momento e RMSprop per fornire un algoritmo di ottimizzazione robusto ed efficiente, ampiamente utilizzato in deep learning.

Conclusioni

La discesa del gradiente stocastico è un componente fondamentale dell’ottimizzazione dei modelli di intelligenza artificiale. La sua efficienza, velocità di convergenza e capacità di generalizzazione lo rendono una scelta ideale per una vasta gamma di applicazioni. Comprendere i principi della SGD e le sue varianti è essenziale per chiunque lavori nel campo dell’AI, poiché rappresenta uno strumento potente per migliorare le performance dei modelli.

Lascia un commento